L’attuale era digitale ha portato con sé cambiamenti tecnologici repentini ed innovazioni importanti ponendo al contempo le aziende di fronte a sfide sempre più complesse in termini di sicurezza dei dati e di gestione delle informazioni.

L’intelligenza artificiale (IA) ha portato innumerevoli benefici per il business delle aziende e ha, tra gli altri, rivoluzionato la capacità delle aziende di valutare il rischio in modo più preciso ed efficace, creando scenari di rischio dettagliati e realistici. Considerando il panorama in costante evoluzione della cybersecurity, l’efficace gestione dei rischi cyber costituisce un tema centrale per le organizzazioni di ogni dimensione e settore, con cospicui vantaggi nella rilevazione di rischi dall’analisi di grandi database, nell’individuazione di specifiche misure di mitigazione e nello sviluppo di strategie cyber aziendali con accurate analisi di contesto, agendo attivamente sul processo di Cyber Risk Management.

L’IA pivot per gli scenari di rischio cyber

L’IA pivot per gli scenari di rischio cyber

L’Intelligenza Artificiale (IA) emerge come un elemento cardine nel contesto dello sviluppo di una robusta strategia di gestione del rischio cyber. Questa tecnologia, seppur con un approccio supervisionato o semi-

supervisionato, assume un ruolo di spicco, specialmente nel quadro del Cyber Risk Management, grazie alla sua capacità di analizzare grandi volumi di dati con precisione e tempestività. In particolare, IA è applicabile a tutte le fasi principali del processo, dall’Information Gathering, all’analisi del rischio e l’identificazione delle azioni di mitigazione dei rischi.

Information Gathering e identificazione degli scenari di rischio

In fase inziale, tecnologie alla base dell’IA come il Natural Language Processing (NLP) e Machine Learning (ad esempio, algoritmi di clustering e classificazione) supportano l’information gathering attraverso l’estrazione e la contestualizzazione di informazioni rilevanti da fonti diversificate (a titolo esemplificativo paper, report, social media, ecc.), identificando pattern e trend emergenti, consentendo una visione aggiornata e completa sulle minacce, mentre l’utilizzo di modelli di rete neurale (come le convoluzionali – CNN – e ricorrenti – RNN) possono aiutare nella classificazione e prioritizzazione di minacce in base alla loro gravità e probabilità di occorrenza. Unitamente, tecnologie di Identification & Analytics, consentono l’identificazione, selezione e raccolta delle minacce da fonti esterne, creando una solida base per l’identificazione delle minacce.

A seconda delle esigenze di compliance o di Assessment, la costruzione di una control checklist completa può essere significativamente automatizzata: l’analisi delle normative, degli standard di sicurezza e delle best practice di settore può essere eseguita sfruttando le potenzialità fornite dai nuovi Large Language Models (es: GPT-4) che consentono analisi di grandi dataset e confrontano continuamente le checklist esistenti con nuove linee guida e standard. Questo assicura che un tool di gestione del rischio rimanga conforme, aggiornato ed allineato ai trend di scenari di rischio, riducendo il carico di lavoro manuale per il personale addetto.

Analisi degli impatti

In fase di analisi, il processo di Business Impact Analysis (BIA) per i processi e le applicazioni aziendali può essere potenziato con l’utilizzo di algoritmi di machine learning che analizzano dati operativi e storici. Modelli predittivi (come le regressioni lineari e modelli di RNN) valutano l’impatto potenziale delle interruzioni, simulando scenari di rischio e fornendo previsioni accurate1. Incrociando questi dati con le checklist di controllo applicate ai processi e alle applicazioni, l’AI può automatizzare la valutazione, confrontando i controlli implementati con le best practice e le normative. Gli strumenti di machine learning, inoltre, utilizzando tecniche di analisi delle serie temporali e modelli statistici, possono suggerire miglioramenti e identificare potenziali lacune, rendendo il processo snello, efficiente ed accurato.

Valutazione del rischio

La valutazione del rischio (Risk Assessment), è l’ambito centrale in cui l’AI può offrire vantaggi significativi. Tra gli altri, modelli di analisi dei dati basati su reti bayesiane e/o Random forest possono fornire una valutazione del rischio precisa e dinamica, analizzando la probabilità e l’impatto delle minacce2. Inoltre, l’AI può identificare le relazioni tra diverse minacce e vulnerabilità, migliorando la comprensione complessiva del rischio attraverso più accurati livelli di esposizione alla minaccia. Tale abilità si traduce nella possibilità per le organizzazioni di acquisire una comprensione approfondita di come eventi specifici ed mirati possano influenzare le operazioni e la sicurezza dei dati.

La capacità di creare scenari di rischio dettagliati si rivela fondamentale nel supportare la pianificazione e l’implementazione di misure di mitigazione proattive e reattive. Questi scenari di rischio possono includere variabili complesse, dalla fluttuazione dei mercati globali alle minacce cyber emergenti. L’AI non solo può riconoscere tendenze e correlazioni altrimenti non facilmente identificabili dai tradizionali metodi di analisi, ma può anche prevedere possibili evoluzioni future basate su modelli storici e attuali. Analogamente, può essere utilizzata per valutare l’impatto finanziario di ciascun scenario, consentendo alle aziende di allocare in modo più efficiente le risorse per la gestione dei rischi.

Raccomandazioni e Reporting

Infine, l’AI può trasformare i dati complessi in visualizzazioni chiare e utili per il management attraverso l’uso di dashboard interattive. Questo supporto è essenziale nel fornire una Gap Analysis e delle raccomandazioni puntuali a supporto del Top Management: tecniche di ottimizzazione e i modelli di apprendimento rinforzato possono ottimizzare l’allocazione delle risorse, garantendo un approccio mirato e proattivo alle misure di sicurezza3. Infine, l’informatica tradizionale supportata da strumenti di data analytics consente di aggregare e analizzare i dati, presentando informazioni cruciali sulle performance di sicurezza, le minacce emergenti e l’efficacia delle misure di mitigazione. Questo supporto visivo facilita la comprensione e il decision-making a livello executive, diventando tecnologie al servizio del livello decisionale della Sicurezza aziendale, accrescendo la sua capacità di essere elemento abilitante per il business.

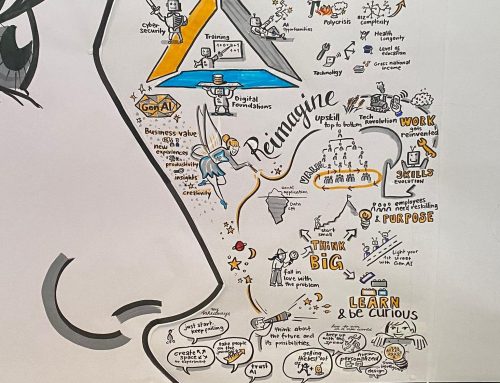

AI e Cybersecurity Strategy delle aziende

La capacità di anticipare ed analizzare scenari di rischio diversificati consente alle aziende di prepararsi meglio e di sviluppare strategie di mitigazione più solide, e questa influenza sarà destinata a crescere nel tempo. Una migliore capacità di analisi predittiva consente di anticipare e individuare le aree di massimo rischio con precisione e tempestività. In concreto, ciò significa che le aziende possono essere informate in modo proattivo sulle vulnerabilità e i potenziali punti critici nei propri sistemi informativi e reti, permettendo loro di adottare misure preventive mirate. Questa capacità predittiva si traduce in una strategia cyber aziendale agile, in grado di adattarsi rapidamente alle minacce in costante evoluzione nel panorama cyber.

Tuttavia, è importante sottolineare che per sfruttare appieno il potenziale dell’IA, è necessario effettuare investimenti significativi nella formazione del personale su benefici, rischi cyber e innovazione dell’infrastruttura tecnologica. Ad esempio, è fondamentale avere sistemi di gestione delle configurazioni (CMDB) e un inventario degli asset ben strutturato per alimentare l’IA con dati di qualità e completi. La qualità del dato che alimenta il modello IA rappresenta un elemento prezioso per il corretto funzionamento dello stesso: infatti, la qualità degli output è direttamente proporzionale a quella degli input, al fine di evitare l’effetto del “Garbage In, Garbage Out”.

Il personale aziendale, tecnico e di business, inoltre, deve essere formato per comprendere e utilizzare in modo efficace le capacità dell’IA sia in termini di benefici portati che nella gestione dei rischi cyber. L’impegno nel know-how e nell’infrastruttura è un passo essenziale per garantire che l’IA possa svolgere appieno il suo ruolo nella definizione di una strategia cyber aziendale resiliente e in grado di adattarsi dinamicamente alle minacce emergenti, mantenendo la sicurezza informatica al centro delle priorità aziendali.

Sfide e Considerazioni Etiche nell’Implementazione dell’Intelligenza Artificiale nel Cyber Risk Management

L’implementazione dell’IA nel Cyber Risk Management comporta sfide tecniche e considerazioni etiche essenziali. La privacy dei dati rappresenta una delle principali sfide, poiché l’IA potrebbe richiedere accesso a dati personali e sensibili per funzionare in modo efficace, suscitando preoccupazioni sulla conformità alle leggi sulla protezione dei dati (es. GDPR). Inoltre, la mancanza di competenze specializzate nell’IA nel campo della sicurezza informatica è un ostacolo da affrontare, richiedendo investimenti nella formazione e nell’acquisizione di talenti.

Dal punto di vista etico, l’utilizzo dell’IA nel monitoraggio continuo e nella gestione delle minacce cyber solleva questioni sulla sorveglianza e controllo delle tecnologie AI-based operanti in settori altamente strategici e, parallelamente, sulla necessità di definire politiche trasparenti e limiti etici chiari. Pertanto, una corretta gestione delle sfide tecniche ed etiche è fondamentale per garantire un’implementazione responsabile dell’IA in ambito cyber.

Implementazione Responsabile dell’IA nel Cyber Risk Management

Nel contesto del Cyber Risk Management, l’adozione responsabile dell’IA richiede un’attenzione scrupolosa rispetto all’utilizzo di pratiche specifiche volte a garantire la sicurezza, la conformità normativa e l’integrità etica. In tal senso, sono apprezzabili i grandi passi avanti fatti da istituzioni di rilievo che hanno emesso direttive chiave e best practice per l’utilizzo responsabile dell’Intelligenza Artificiale (IA). A titolo non esaustivo:

- Nel 2019, il Gruppo di Esperti dell’UE ha proposto le “Linee Guida Etiche per un’IA Affidabile”, mentre l’OCSE ha delineato principi nell’uso etico dell’IA;

- nel 2022, l’Università di Oxford ha introdotto la “Procedura Cap AI” per valutare la conformità dei sistemi di IA con la proposta “Artificial Intelligence Act” della Commissione UE nel 2021;

- nel 2023, vengono definiti i primi standard in ambito AI Risk Management:

- il NIST ha pubblicato il “NIST 100-1 – AI Risk Management Framework” per gestire rischi associati all’IA;

- ENISA ha proposto un “Multilayer framework” per la sicurezza informatica nell’intero ciclo di vita dell’IA. A livello europeo invece, un primo passo è stato compiuto con l’AI Act.

- È definita la ISO/IEC 23894:2023, ovvero il primo Standard per per lo sviluppo, la produzione, la distribuzione e l’utilizzo di prodotti, sistemi e servizi AI-based per il Risk Management in ambito AI.

- È definito il primo Standard per i Sistemi di gestione dell’Intelligenza Artificiale, l’ISO 42001, affrontando considerazioni specifiche come l’apprendimento continuo, la trasparenza e l’etica. Include aspetti chiave come la gestione dei rischi, la sicurezza, l’equità, la qualità dei dati e la responsabilità.

In tale contesto, inoltre, si pone l’introduzione del Regolamento Europeo in materia di AI. L’EU AI Act, approvato dapprima dal Parlamento Europeo il 13 marzo 2024 e successivamente dal Consiglio Europeo in data 21 maggio 2024, rappresenta il primo quadro normativo completo sviluppato dall’UE per governare l’uso e lo sviluppo dell’IA.

L’EU Artificial Intelligence Act (AI Act), pubblicato il 12 luglio 2024, introduce tra gli altri elementi cardine di sicurezza – quali un severo approccio risk-based per la classificazione e valutazione dei sistemi IA, regole di trasparenza e non discriminazione, tracciabilità e supervisione, gestione strutturata degli incidenti e relativa notifica, nonché gestione appropriata e secondo un approccio risk-based della supply chain. Tali elementi diventeranno vincolanti per tutti gli Stati membri dell’UE con non poche implicazioni di varia natura e complessità per il panorama di sviluppo tecnologico e industriale

Non da ultimo, nell’aprile 2023 il Consiglio dei ministri n. 78 ha approvato un primo disegno di legge (DDL S. 1146) per l’introduzione di disposizioni e la delega al Governo in materia di intelligenza artificiale (AI), in continuità con l’AI Act dell’UE. Questo DDL mira a bilanciare le opportunità offerte dalle nuove tecnologie con i rischi legati al loro uso improprio, sottoutilizzo o impiego dannoso, delineando una strategia nazionale, le autorità competenti, le azioni di promozione, la tutela del diritto d’autore e il sistema sanzionatorio. Si aggiunge, infine, la Strategia Italiana per l’Intelligenza Artificiale, pubblicata ufficialmente il 22 luglio 2024, dedicata principalmente all’utilizzo strategico di tale tecnologia negli ambiti della Ricerca, della Pubblica Amministrazione, della Formazione e delle Imprese. La Strategia propone inoltre un sistema di monitoraggio rispetto all’attuazione e al contesto regolativo entro il quale sarà impiegata.

Pertanto, al fine di ottenere una corretta implementazione dell’IA in questo contesto, si rende necessario definire un approccio olistico alla tematica, che comprenda a titolo non esaustivo la gestione dei seguenti elementi:

- Governance: Stabilire una governance chiara per l’uso dell’IA nel Cyber Risk Management è fondamentale, inclusa l’assegnazione di responsabilità specifiche, la definizione di procedure di segnalazione degli abusi e la creazione di meccanismi di Monitoring & Control. Infine, continua interlocuzione con le Autorità di settore e delle Istituzioni deputate al tema della gestione dell’alta intensità tecnologica. Degli strumenti di supporto in tal senso sono reperibili sul Catalogue of Tools & Metrics for Trustworthy AI4 dell’OECD.AI Policy Observatory, dov’è possibile analizzare degli use-case per ogni tipo di framework proposto. Tra quelli a catalogo, possiamo menzionare il Responsible AI Governance Framework for boards, il quale è basato su 12 principi per l’utilizzo responsabile dell’AI nella propria organizzazione, in conformità con l’EU AI Act e la ISO/IEC 42001 AI Management System.

- Trasparenza: Le organizzazioni devono fornire una chiara e completa divulgazione delle capacità dell’IA, compresi i suoi limiti e le modalità di utilizzo previste, al fine di instillare fiducia tra utenti e stakeholder. Tra gli altri, due casi emblematici sul tema della Transparency sono rappresentati da ANTHROPIC per il prodotto Claude 3.5 Sonnet5 e da META per il prodotto Llama 3.16.

- Privacy e Conformità: L’aderenza rigorosa alle leggi sulla privacy dei dati è fondamentale, compresa l’esplicito consenso richiesto per la raccolta e l’elaborazione dei dati. L’impiego di tecniche di encryption, pseudonimizzazione e anonimizzazione dei dati dovrebbe infatti diventare una pratica standard per massimizzare la protezione della privacy, pur considerando la territorialità e i confini dell’impianto normativo, nonché la relativa implementazione settoriale e territoriale.

- Valutazione degli Impatti: Le organizzazioni devono valutare e monitorare periodicamente degli impatti sulla privacy e sull’etica per identificare e mitigare potenziali rischi di violazione.

- Formazione e Supervisione: Il personale coinvolto nell’implementazione dell’IA necessita di una formazione adeguata e una supervisione continua per garantire un utilizzo responsabile dell’IA. Questa formazione dovrebbe coprire anche aspetti etici e legali legati all’utilizzo della tecnologia.

- Audit di Sicurezza e Certificazioni di Conformità: Deve essere effettuata regolarmente l’attività di Audit di Sicurezza per garantire la conformità alle politiche e alle leggi relative all’uso dell’IA. Ove necessario, dovrebbero essere condotti audit indipendenti da terze parti, in conformità tra gli altri alla ISO 42001:2023. .

- Coinvolgimento degli Stakeholder: Coinvolgere attivamente le parti interessate, tra cui dipendenti, clienti e comunità, è fondamentale per garantire che l’uso dell’IA sia accettato e sostenibile in modo trasversale e intersettoriale, necessitando di cooperazione e partnership pubblico-private.

- Interoperabilità e cost-saving: In una fase di transizione, seppur dirompente, è necessario considerare una integrazione di tecnologie AI-based tra piattaforme e tool di analisi del rischio già presenti sul mercato. Questo consentirebbe un avvicinamento graduale alla tecnologia ed un processo di “assimilazione culturale” e sostenibilità economica che faciliterebbe l’interoperabilità tra sistemi già in uso, riducendo i costi e permettendo investimenti graduali. Non per ultimo, non produrrebbe effetti boomerang sul mercato, salvaguardando partnership user-vendor già consolidate.

Con l’obbiettivo di sviluppare una governance efficace, basata su tali princìpi, Bip CyberSec può supportare le aziende in attività di Maturity Assessment rispetto ai requisiti di compliance dell’AI Act e nel rispetto di standard e framework di riferimento, quali – tra gli altri già citati – il MITRE AI Maturity Model.

L’implementazione dell’IA nel Cyber Risk Management richiede quindi un impegno tangibile per garantire sicurezza, conformità ed etica. Fissando questi princìpi organizzativi, le aziende possono affidarsi alle tecnologie all’avanguardia cosiddette AI-based per affinare le proprie capacità di analisi strategica. Tuttavia, è necessario mantenere alti gli standard di integrità e responsabilità e proteggere le informazioni trattate nell’utilizzo di tali tecnologie. In questo modo, le organizzazioni utilizzeranno la gestione del rischio per generare valore aziendale e accrescere al tempo stesso un vantaggio competitivo.